Bu ayki gök olaylarından biri çok özel: Ömrümüz boyunca bir daha şahit olamayacağımız kadar nadir, ama bilim tarihinde “18. yüzyılın Apollo programı” olarak anılacak kadar önemli bir yeri var.

6 Haziran sabahı Venüs gezegeni Dünya’yla Güneş’in arasından geçecek ve Güneş’in küçük bir kısmını kapatacak. Yani Dünya’ya Venüs’ün gölgesi düşecek. Ancak Venüs çok uzakta olduğu için, özel araçlarla gözlenmezse farkında bile olamayacağımız kadar küçük bir gölge bu.

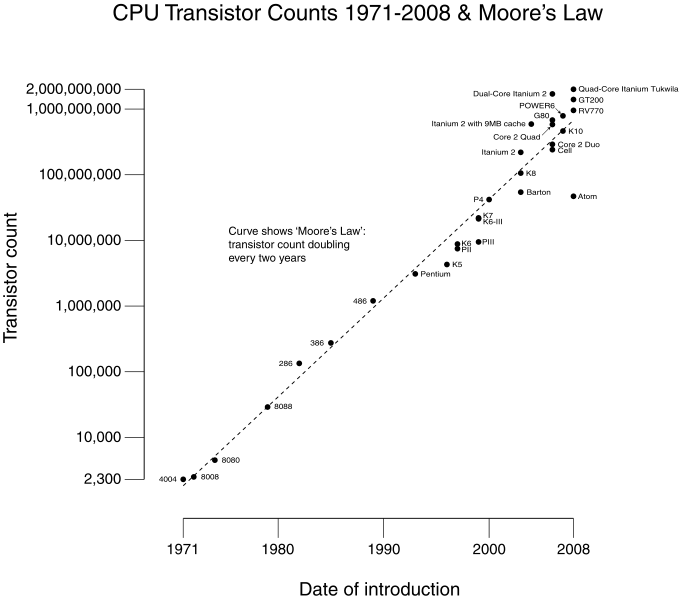

Venüs geçişi tabir edilen bu olay teleskoplu gözlemlerin başlamasından bu yana sadece yedi sefer gözlendi (1631, 1639, 1761, 1769, 1874, 1882 ve 2004 yıllarında). Elbette bu geçişler aksak da olsa bir düzene sahip. Hesaplara göre iki geçiş arasında 8, 121.5, 8, ve 105.5 yıl geçmesi gerekiyor; sonrasından aynı kalıp tekrarlanıyor. Geçişler sadece Haziran başı veya Aralık başında olabiliyor.

Bu ay, sekiz yıl farkla gerçekleşen bir çiftten ikincisini yaşayacağız. Bir sonraki geçiş ancak 2117 yılının 11 Aralık günü görülebilecek.

Kozmik cetvel Venüs

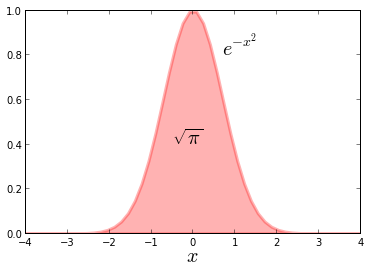

Venüs geçişi sadece ilginç bir olay olmakla kalmıyor, astronomi tarihinde önemli bir yeri var. Çeşitli tarihlerdeki bu geçişler Güneş sisteminin boyunu ölçmek için bir “cetvel” gibi kullanıldı, Dünya-Güneş mesafesinin yaklaşık 150 milyon kilometre olarak belirlenmesini sağladı.

Onsekizinci yüzyıla gelene kadar, her gezegenin Güneş çevresinde attığı turun kaç yıl sürdüğü hassasiyetle ölçülmüştü. Dönme süresi bilindiğinde de, Kepler’in üçüncü kanunu sayesinde gezegenin Güneş’ten mesafesi bulunabiliyordu. Ama Kepler yasası bu mesafeleri kilometre olarak değil, Dünya-Güneş mesafesinin oranı olarak vermeye uygundu sadece. Eğer Dünya-Güneş mesafesi ölçülebilirse, bütün diğer gezegenlerarası mesafelerin kaç kilometre olduğu hesaplanabilecekti.

1677′deki Merkür geçişini izleyen astronomlardan 21 yaşındaki Edmond Halley (daha sonra kendi adıyla anılan kuyrukluyıldızı keşfedecek olan), gezegenlerin Güneş önünden geçişlerinin Güneş-Dünya mesafesini hesaplamak için kullanılabileceğini farketti.

Resim: Venüs’ün geçişi yeryüzünün farklı yerlerinden gözlenince değişik yollar izler gibi görünür. (Wikipedia)

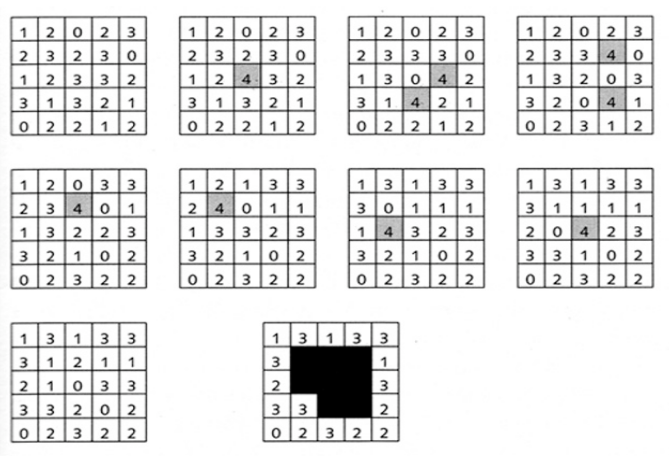

Halley Venüs geçişini Dünya’nın birbirinden uzak bölgelerinden gözlemeyi teklif etti. Kolunuzu ileri uzatarak başparmağınızı havaya kaldırın ve önce bir gözünüzle, sonra öbür gözünüzle bakın; arkada kalan cisimler başparmağınızın bir soluna bir sağına geçecektir. Bu etkiye “paralaks” adı verilir. Paralaks sebebiyle Venüs’ün Güneş üzerinde takip ettiği yol, değişik gözlem noktalarından çok az da olsa farklı görünecektir. Geçişin başlama ve bitme zamanları da farklı olacaktır. Bu farkları kaydederek Dünya-Güneş mesafesini, oradan da Venüs’ün ve Güneş’in büyüklüğünü hesaplamanın mümkün olduğunu farkeden Halley, bir sonraki Venüs geçişi zamanında uzak bölgelere bilim seferleri düzenlenmesini teklif etti. 1761′de gerçekleşecek olan geçişe ömrünün yetmeyeceğinin bilse de, gözlemleri işleyecek gerekli teorik hesaplamaları yaparak gelecek nesil astronomları gerekli gözlemleri yapmaya teşvik etti.

Resim: 2004 geçişinde Hindistan (kırmızı), Avustralya (yeşil) ve İspanya (mavi) gibi uzak noktalardan yapılan ölçümlerin üstüste bindirilmiş hali. Paralaksın ne kadar küçük olduğu görülebiliyor. (National Solar Observatory, ABD.)

Venüs şart değil tabii; Merkür’ü gözleyerek de aynı iş yapılabilir, hem de Merkür’ün geçişleri daha sık (yüz yılda 13-14 kere) olduğu için daha çok fırsat bulunur. Ama Merkür Venüs’e göre epeyce hızlı hareket ettiği için geçiş daha çabuk biter, gözlem için zaman daha dardır. Ufaklığından dolayı Merkür’ü gözlemek daha zor olacaktır. Üstelik Merkür Güneş’e daha yakın olduğu için zaten küçük olan paralaks etkisi iyice küçülecektir. Bu sebeplerle Venüs geçişi kaçırılmayacak bir fırsat olarak görüldü.

1761 ve 1769 geçişleri

1761′i görmeye Halley’in ömrü yetmese de, önayak olduğu bilimsel hazırlıklar tamamlanmıştı. Ancak o dönemde dünya Yedi Yıl Savaşları ile kaynamaktaydı. Avrupalı güçler arasındaki savaş Amerika, Afrika ve Hindistan’daki kolonilere yayılmış, deniz yollarının emniyeti ortadan kalkmıştı. Yine de çeşitli ülkelerden bilim adamları yola çıkmaktan çekinmediler. Bazıları hedeflerine ulaşamadı, bazıları ise astronominin o zaman bugünkünden çok daha heyecanlı bir meslek olduğunu düşündüren maceralar yaşayarak gözlemlerini yapmayı başardı. Bu ekipler Sibirya, Kanada, Güney Afrika, Hindistan, ve tabii Avrupa’nın çeşitli yerlerinde 62 ayrı ölçüm yaptılar.

Fakat sürpriz bir fenomen ölçümlerin isabetliliğini azaltmıştı. Halley’in teklif ettiği yöntem, Venüs’ün yuvarlağının kenarının Güneş’in kenarına temas anının bir saniyelik hassasiyetle kaydedilmesini gerektiriyordu. Fakat Venüs ve Güneş’in kenarları değmeye yaklaşınca iki dairenin arasında damla biçimi bir yayılma görülüyor, temas anı ancak otuz saniyelik bir hata payı ile ölçülebiliyordu. Bu “Kara Damla” etkisi, başka açılardan çok hassas olan ölçümlerin hata payını büyük miktarda artırıyordu.

Sekiz yıl sonra bir şansları daha olduğunu bilen astronomlar, kara damla etkisini hesaba katarak tekrar hazırlıklara başlamışlardı. 1769’da, savaş bittiği için nispeten emniyetli hale gelen bir ortamda, İngiliz, Fransız, İspanyol, Rus, ve kolonilerden Amerikalı bilim adamları yine dünyanın dört bir tarafına dağıldılar. Uzak coğrafyalardaki tehlikeler yüzünden gerçek birer maceraya dönüşen bu geziler sonucunda tam 77 değişik konumdan rasatlar yapıldı.

Bu seferlerden biri, daha sonra ün kazanacak kaptan James Cook’un ilk keşif gezisiydi. Geçişi Tahiti’de kaydeden Cook’a, geri dönmeden önce, o zamanlar mevcut olduğu zannedilen büyük güney kıtasını araması emredilmişti. Böyle bir kıta bulunamadı, ama Cook, Venüs geçişi için çıktığı yolculuk sırasında Avustralya’nın doğu kıyılarını, Yeni Zelanda’yı, ve sayısız Pasifik adasını keşfetti.

Sonraki yıllarda Fransız astronom Jerome Lalande, 1761 ve 1769 geçişlerinde yapılan ölçümleri birleştirerek Dünya-Güneş arası mesafeyi 153 milyon kilometre olarak açıkladı. Kara damla etkisi yüzünden bu tahmindeki hata payı 1 milyon kilometre gibi yüksek bir değerde çıktı.

Kara damla etkisine neyin sebep olduğuna dair çeşitli tahminler yapılsa da, yakın zamana kadar kesin bir cevap bulunamamıştı. 1999’da astronom Jay Pasachoff, TRACE uydusuyla yapılan Merkür geçişi gözlemlerini inceledi. Kara damla yine mevcuttu, ama Merkür’ün atmosferi olmadığı, gözlem de uzaydan yapıldığı için, etkinin atmosferlerden kaynaklanmadığı anlaşıldı.

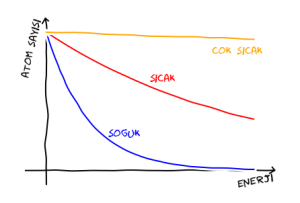

Pasachoff’un analizine göre kara damlanın sebeplerinden biri her teleskopta az veya çok bulunan bulanıklaştırma etkisi. Diğer sebep ise Güneş’in bir gaz topu olması, keskin bir bitiş yerinin bulunmaması. Güneş diskinin hemen dışı siyah görünse de, orası boşluk değil, nispeten daha soğuk olduğu için karanlık görünen gazla dolu bir bölge. Bu iki etkinin birleşimi kara damlaya yol açıyor. Bugün gelişkin teleskoplar ve uydular sayesinde çok daha temiz gözlemler yapılabiliyor, veri işleme yöntemleri sayesinde kara damla tamamen ortadan kaldırılabiliyor.

1874 ve 1882 geçişleri

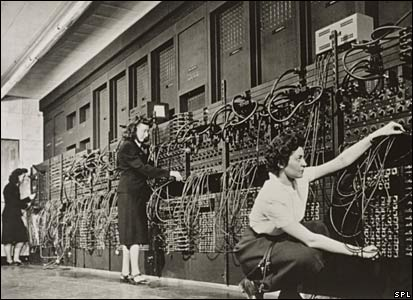

Aradan geçen 105 yılda hassas rasat araçları barındıran gözlemevleri yerkürenin birbirinden uzak bölgelerine yayılmıştı. Yeni Venüs geçişleri zamanı geldiğinde eskisi kadar çok sayıda ekipler oluşturmak gerekmedi. Kerguelen adası gibi özel yerlere bilimsel seferler yine düzenlendi, ama çoğu gözlem yerleşik astronomlar tarafından yapıldı. Telgraf, demiryolları ve buharlı gemiler sayesinde iletişim çok hızlanmıştı ve koordinasyon çok daha rahat sağlandı. Dahası o dönemde fotoğrafçılık icat edilmiş, insan gözüne güvenmek gerekmeden geçişin kayıt altına alınması mümkün olmuştu.

Kara damla yine mevcuttu, ama gelişmiş teleskoplar ve fotoğraflama tekniği sayesinde hata payı azaltılabilmişti. Bu geçişlerde ve 1761-1769 geçişlerinde elde edilen verilerin birleştirilmesiyle Dünya-Güneş mesafesi 149.59 milyon kilometre olarak tespit edildi, 0.31 milyon kilometrelik bir hata payıyla.

Venüs’ün verebileceği bilgi bu kadardı. Kısa süre sonra 1898’de keşfedilen göktaşı Eros, aynı ölçümü daha hassas yapma imkânı sağladı. Dünya’ya yakın geçmesi sayesinde Eros daha büyük bir paralaks sağlayacak, atmosferi olmadığı için çeperinde bulanıklık görülmeyecek, dolayısıyla hata payı çok azalacaktı. Bilimciler yeni bir rasat seferberliğine girişti, ve Eros rasatları sayesinde 20. yüzyılda Dünya-Güneş mesafesi sadece birkaç bin kilometrelik hata payıyla belirlenebildi. Bu sonuç ne kadar etkileyici olsa da, sadece otuz yıl sonra aşıldı.

Sonraki yıllarda yakın gökcisimlerinin mesafelerinin radarla tespit edilebilmesi, Dünya-Güneş mesafesini çok büyük bir hassasiyetle belirleme imkânı verdi. Bugün kabul edilen değer 149,597,870,691 metre. Hata payı ise sadece 30 metre. Bu, bir insanın boyunu sadece bir atomun büyüklüğü kadar bir hata payıyla ölçmeye denk bir hassasiyet.

Halley torunları ile kesinlikle gurur duyardı.

Yeni bir amaç

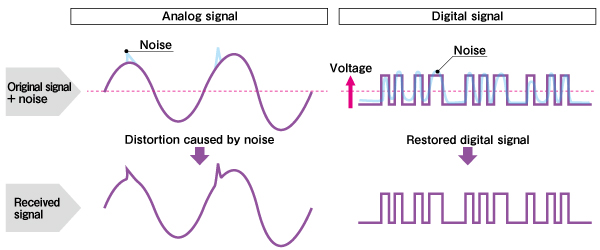

Geçişler hâlâ astronomi camiasi için önemli gözlem fırsatları sağlıyor, ama bu seferki amaç değişik. Astronomlar, bir yıldızın önünden bir gezegenin geçmesinin ne çeşit görünür etkiler yarattığını ölçmek istiyorlar.

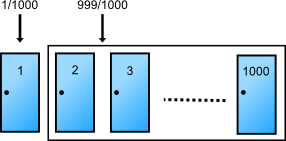

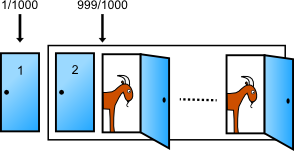

Son yirmi yılda astronomlar uzak yıldızların çevresindeki gezegenleri tespit edebilmeye başladılar. Olağanüstü hassas ölçümler gerektiren bu gözlemler için çeşitli yöntemler kullanılıyor. Bunlardan biri gezegen geçişi yöntemi. Bir gezegen, yıldızının önünden geçerken yıldızın ışığı birazcık azalır, sonra eski haline gelir. Gezegenin kendisi görülemese de, yıldızın ışığının değişimi ile gezegenin büyüklüğünü ve periyodunu, dolayısıyla yıldızdan uzaklığını, yaşamaya uygun sıcaklıkta olup olmadığını tahmin etmek mümkün olur.

Resim: Kepler programı, yıldızların ışığındaki periyodik azalmaları gözleyerek yörüngelerindeki gezegenleri tespit etmeyi amaçlıyor. (NASA Ames Research Center/Kepler Mission)

Gezegen geçişi yöntemi her zaman işlemez. Öncelikle, gezegenin yörüngesinin Dünya’dan bakış çizgimizle hizalanmış olması lâzım, yoksa gezegenin “gölgesi” üzerimize düşmez. Ayrıca algılamanın çok hassas olması gereklidir (binlerce kilometre ötedeki bir ateşböceğine bakarak, yanıp sönmesini değil, ışığındaki küçük oynamaları algılamaya çalıştığınızı düşünün). Bu sebepler yüzünden geçiş yöntemi ile Dünya benzeri küçük gezegenler değil, yaklaşık Jüpiter büyüklüğündeki dev gezegenler algılanabiliyor. Bu zorluklara rağmen yöntem başarılı oluyor.

NASADışGezegenKataloğu’na göre, şimdiye kadar tespit edilmiş olan 691 dış gezegenden 188’i geçiş yöntemiyle saptanmış.

Gezegen geçişi sırasında yıldız ışığı sadece azalmakla kalmıyor, gezegenin atmosferinden geçerek geldiği için spektrumu, yani renkleri de değişiyor. Değişen spektruma bakarak gezegenin atmosferinde hangi gazlar bulunduğunu kestirmek mümkün.

Venüs geçişi burada devreye giriyor. Geliştirilen bu hassas tekniklerin doğru işleyip işlemediğini anlamak, varsa hatalarını ortaya çıkarmak için bir deneme sürüşü yapmak lâzım. Venüs’ün atmosfer yapısını zaten biliyoruz. Geçiş sırasında yapılacak gözlemler bildiklerimize uyan sonuçlar verirse ne âlâ, yoksa araçları tekrar gözden geçirmek gerekecek.

İşi zorlaştıran bir etken daha var. Bu gözlem Hubble teleskobu ile yapılacak, ama Hubble doğrudan Güneş’e bakamaz, yoksa hassas alıcı devreleri şiddetli Güneş ışığı ile kavrulur. Bu yüzden astronomlar geçiş günü Hubble’ı ters yöne, Ay’a doğrultacaklar ve Ay’dan yansıyan zayıf ışığı kaydedecekler.

Nasıl gözlemeli?

Geçiş, Türkiye saatiyle 6 Haziran 01:05’de başlayacak, 07:55’de sona erecek. Venüs Güneş’in üst kısmından geçtiği için Güneş tam yükselmeden de görebilirsiniz. Fotoğraf çekmek için gündoğuşu güzel bir enstantane sağlayabilir, ama daha sonra güçlü bir Güneş filtresi gerekir.

KESİNLİKLE ÇIPLAK GÖZLE, GÜNEŞ GÖZLÜĞÜYLE, İSLİ CAMLA VEYA DÜRBÜNLE GÜNEŞE BAKMAYIN. Eğer 1999 veya 2006 güneş tutulmaları için özel gözlüklerden almış ve bir köşede saklamışsanız onları kullanabilirsiniz. 14 numara (en koyu renklisi) kaynakçı camı kullanmak da güvenlidir.

Teleskobunuz varsa, Güneş’e yönlendirip (içine ASLA bakmadan), göz kısmının arkasına bir beyaz kâğıt tutarak Venüs’ün gölgesini görebilirsiniz.

Resim: Venüs geçişinin görülebileceği bölgeler. Geçiş, Türkiye’nin de dahil olduğu yeşil renkli alanda 6 Haziran sabahı gün doğumundan önce başlamış olacak. (NASA)

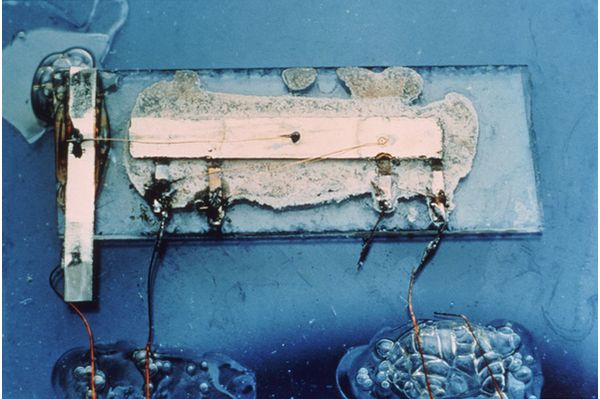

Tavsiye edilen başka bir yol “kutu kamera” yapmak. Bir tarafı uzunca bir kutu alın. Küçük yüzlerini kesip atın. Yüzlerden birini alüminyum folyoyla kaplayın. Folyonun ortasına, bir toplu iğnenin ucuyla küçük bir delik açın. Delik ne kadar küçük olursa o kadar iyi. Kutunun öbür ucuna yakın bir yerde yanına bir pencere kesin. O pencereden kutunun kapalı yüzüne düşen güneş görüntüsünü seyredebilirsiniz. Uzun bir kutunuz varsa Güneş daha büyük gözükecektir. Ayrıntılar için Exploratorium websitesindeki resimlere bakabilirsiniz.

Daha profesyonel bir ortam arzu ediyorsanız, geçiş sırasında halka açık olan AnkaraÜniversitesiRasathanesi‘ni ziyaret edebilirsiniz. İmkânınız yoksa, bulunduğunuz yerde hava bulutlu ise, veya sabahın köründe açık alana gidemiyorsanız, NASA‘nıninternettenyapacağınaklenyayını seyredebilirsiniz.

Her halükarda 6 Haziran sabahı işe giderken Güneş’e yan gözle bir anlığına bakın, bu tecrübeyi hiç olmazsa hayalinizde canlandırarak yaşayın ve astronomların yüzlerce yıllık heyecanına ortak olun.

Kaynaklar

- Hawaii Mauna Kea Gözlemevi’nden canlı yayın: http://sunearthday.nasa.gov/2012/transit/webcast.php

- NASA’nın tutulmalar uzmanı Fred Espenak’ın teknik bilgiler içeren sitesi: The 2012 Transit of Venus. http://eclipse.gsfc.nasa.gov/OH/transit12.html

- Venüs geçişlerinin tarihi, astronomik ayrıntılar, gözlem yapma teknikleri

○ http://transitofvenus.nl/wp/

○ http://www.transitofvenus.org/

- NASA Venüs Geçişi sayfası. http://venustransit.nasa.gov/2012/transit/index.php

- Hubble to Use Moon as Mirror to See Venus Transit http://www.nasa.gov/mission_pages/hubble/science/transit-mirror.html

- Ankara Üniversitesi Rasathanesi – Venüs’ün Güneş Diski Önünden Geçişi http://rasathane.ankara.edu.tr/2012/Venus_Gecisi.htm

Kevin Wigell http://www.kwastronomy.com/Venus_Transit_2004.htm